AMD 很高興地發表首次 MLPerf 基準測試之結果,並在更新的MLCommons網站上展示搭載 AMD Instinct™ MI300X GPU 進行測試的結果。

MLPerf 有多種基準測試類型,包括 MLPerf Inference: Datacenter、MLPerf Training 以及於 2024 年推出的尖端大型生成式人工智慧(AI)語言模型 Llama 2 70B。AMD 選擇了受歡迎且具有重要意義的大型語言模型(LLM)Llama 2 70B 進行首次 MLPerf 基準測試。

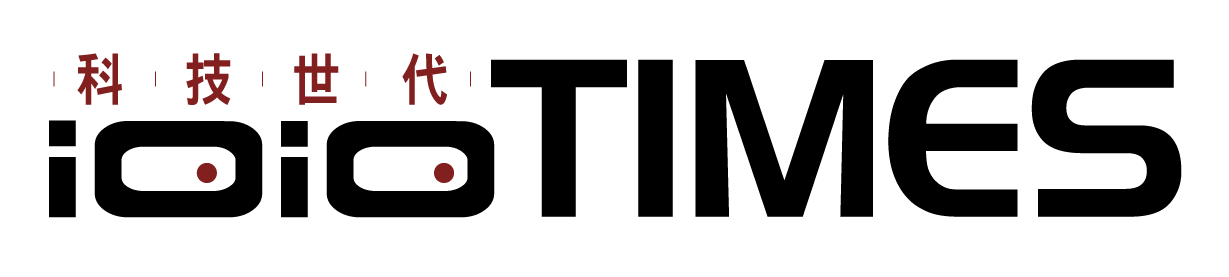

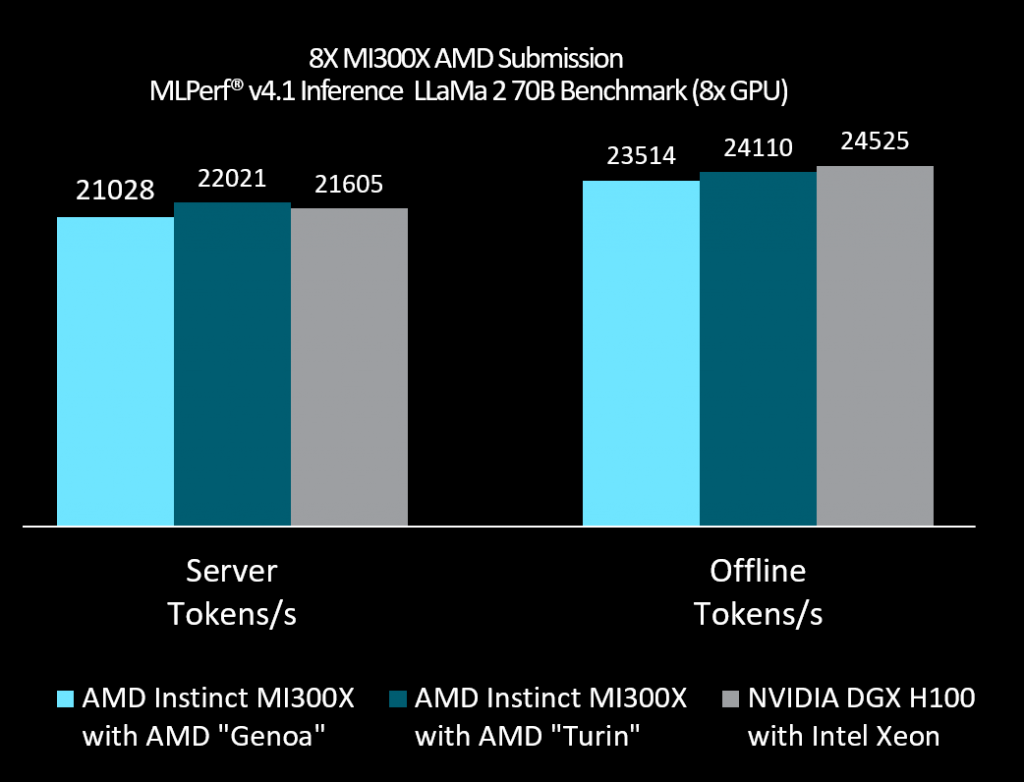

AMD 在 MLPerf Inference v4.1(MLPerf 4.1 推論)中為 Llama 2 70B 提出 3 項成果並展示出:

· 市場上最適合用於 AI 任務的 AMD CPU 和 GPU 組合。

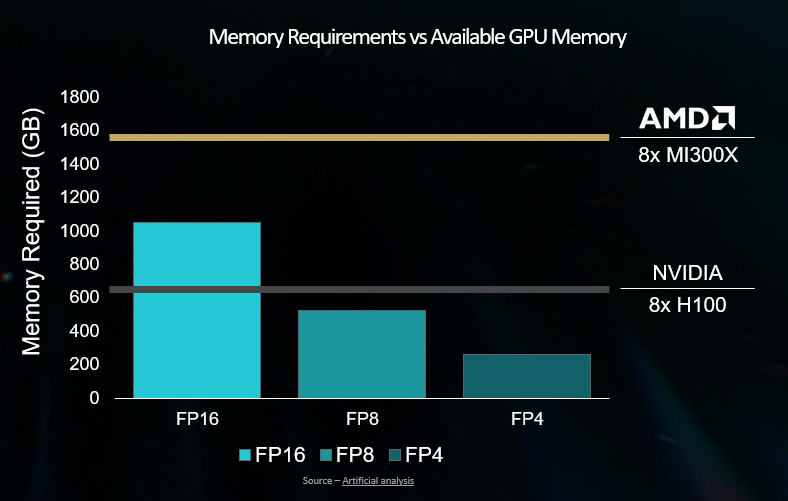

· MI300X 擁有 192GB 的大容量記憶體,讓單一 MI300X GPU 可執行整個 Llama 2 70B 模型,而大多數競爭對手的 GPU 則需要將該模型拆分至多個加速器上執行。

· AMD 新一代 CPU 如何提升 AI 任務的效能。

在 MLPerf 4.1 推論中,AMD 的結果展現出搭載 ROCm 的 MI300X 為 Llama 2 70B 等大型 LLM 提供卓越的推論效能,且與其他業界領先者如 Nvidia H100 在 Llama 2 70B LLM 模型上的測試結果不分軒輊。

欲了解更多相關資訊,請參閱 AMD部落格文章。