Fireworks AI等客戶使用全新OCI運算執行個體執行AI推論與訓練工作負載

OCI Supercluster在雲端服務供應商中處於領先地位,在單一超高速網路架構中支援多達16,384個AMD Instinct MI300X GPU

AMD(NASDAQ: AMD)宣布 Oracle Cloud Infrastructure (OCI) 採用 AMD Instinct™ MI300X 加速器與ROCm™開放軟體,為最新的 OCI Compute Supercluster 執行個體(instance)BM.GPU.MI300X.8 提供動能。對於含有數千億參數的 AI 模型來說,搭載 AMD MI300X的OCI Supercluster 憑藉與其他 OCI 加速器相同的超高速網路架構(ultrafast network fabric)技術,可在單一叢集中支援高達 16,384 個 GPU。這些 OCI 的裸機執行個體(bare metal instance)設計旨在執行各種要求嚴苛的 AI 工作負載,包括需要高吞吐量的大型語言模型(LLM)推論與訓練,且具備領先業界的記憶體容量與頻寬,現已被 Fireworks AI 等企業所採用。

AMD 全球副總裁暨資料中心 GPU 事業群總經理 Andrew Dieckmann 表示,AMD Instinct MI300X 與 ROCm 開放軟體的發展動能持續成長,成為深受客戶信賴的解決方案,以執行最關鍵的 OCI AI 工作負載。隨著這些解決方案進一步擴展至持續成長的 AI 密集型市場中,此組合將為 OCI 客戶帶來高效能、高效率以及絕佳的系統設計彈性。

Oracle Cloud Infrastructure 軟體開發資深副總裁 Donald Lu 表示,AMD Instinct MI300X 加速器的推論能力增加了 OCI 廣泛的高效能裸機執行個體選擇,以消除 AI 基礎架構常用的虛擬化運算所帶來的開銷。我們很高興為客戶提供更多選擇,以具有競爭力的價格加速 AI 工作負載。

為AI訓練與推論帶來值得信賴的效能與開放選擇

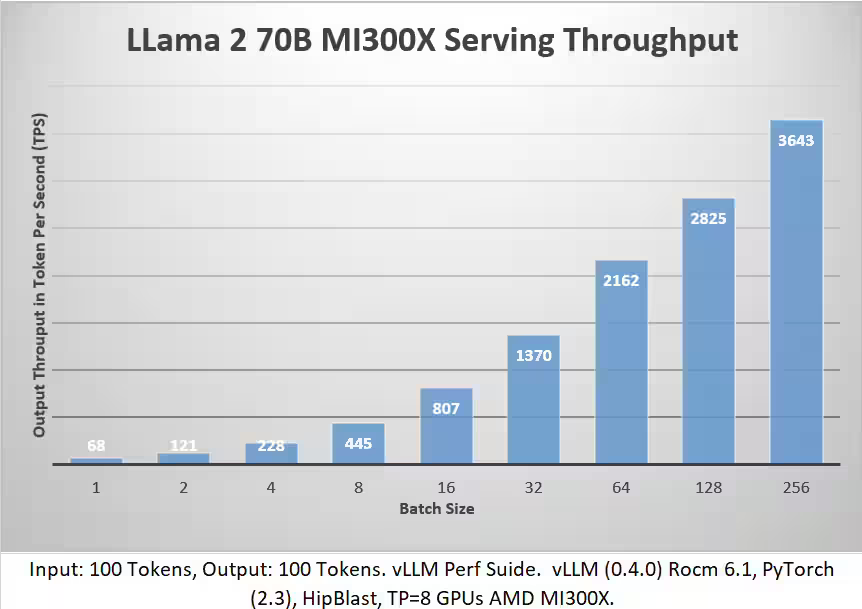

AMD Instinct MI300X 通過 OCI認證的嚴密測試,凸顯其滿足延遲最佳化(latency-optimal)使用案例的 AI 推論與訓練能力,在較大批量(batch size)下,可在單一節點上容納最大的 LLM 模型。Instinct MI300X 具備的這些效能優勢引起了 AI 模型開發者的關注。

Fireworks AI 提供一個高速的平台,以建構與部署生成式 AI。擁有超過 100 個模型的 Fireworks AI 正在發揮 OCI 中 AMD Instinct MI300X 所帶來的效能優勢。

Fireworks AI 執行長 Lin Qiao 表示,Fireworks AI 協助企業在廣泛的產業和使用案例中建構與部署複合式 AI 系統。AMD Instinct MI300X 與 ROCm 開放軟體提供的記憶體容量,讓我們能為客戶擴展服務以因應持續成長的模型。