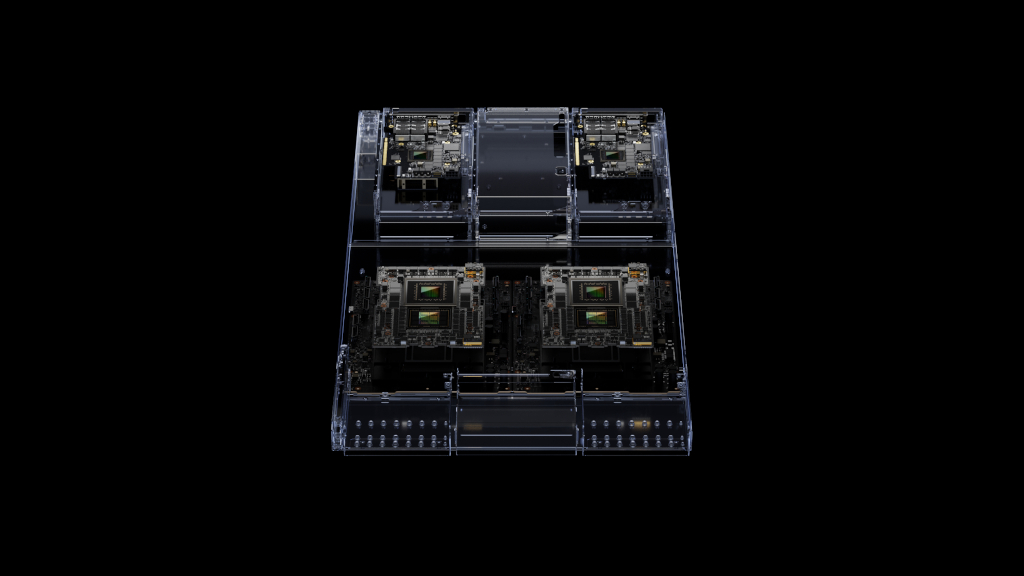

全球首款 HBM3e 處理器提供開創性的記憶體和頻寬;可連接多個 GPU以達到極致效能表現;易於擴充的伺服器設計

NVIDIA 今日宣布推出新一代 NVIDIA GH200 Grace Hopper 平台,該平台專為加速運算和生成式人工智慧時代而打造,採用全新 Grace Hopper Superchip 與全球首款 HBM3e 處理器。

此全新平台將提供多種配置,可用於處理世界上最複雜的生成式人工智慧工作負載,包括大型語言模型、推薦系統和向量資料庫。

此新平台採用雙配置:記憶體容量和頻寬分別是市面上產品的 3.5 倍和 3 倍,包括一台擁有 144 個 Arm Neoverse 核心、8 petaflops 人工智慧運算效能,以及 282GB 最新 HBM3e 記憶體技術的伺服器。

NVIDIA 創辦人暨執行長黃仁勳表示:「為滿足市場對生成式人工智慧不斷增長的需求,資料中心需要有能夠滿足專屬需求的加速運算平台。全新 GH200 Grace Hopper Superchip 平台以其出色的記憶體技術和頻寬,加大了資料處理能力;能夠連接多個 GPU,將效能聚集不減損;並為可以輕鬆部署到整個資料中心的伺服器設計。」

新平台採用 Grace Hopper Superchip,可以透過 NVIDIA NVLink 高速 GPU 互連技術與其他超級晶片互連與協同工作,為生成式人工智慧部署所需的巨型模型。

這個高速連貫的技術,可以讓 GPU 徹底存取 CPU 記憶體,在雙配置時提供合計 1.2TB 的高速記憶體。

HBM3e 記憶體的存取速度比當前的 HBM3 快上 50%,可提供合計每秒 10TB 的頻寬,讓新平台能夠運行比前一個版本大上 3.5 倍的模型,同時以快三倍的記憶體頻寬提高整體執行效能。

對Grace Hopper的需求日增

各大主要製造商已經開始提供搭載先前發布之 Grace Hopper Superchip 的系統。為推動市場更廣泛採用這項技術,搭載 HBM3e 的下一代 Grace Hopper Superchip 平台與今年稍早在台北國際電腦展發表的 NVIDIA MGX 伺服器規範完全相容。任何系統製造商藉助 MGX,都能以符合成本效益的方式,快速將 Grace Hopper 加入 100 多款伺服器內。

供貨時程

各大系統製造商預計於 2024 年第二季推出基於此平台的系統。