在上個月的 CES 大展中,NVIDIA 藉著發布 RTX Super 系列就已經預告將推出全新的 RTX AI 軟體工具,除了即將登場的 AI Workbench 之外,TensorRT-LLM(TRT-LLM) 以及透過 TRT-LLM 加速的 Chat With RTX 也將正式上陣。

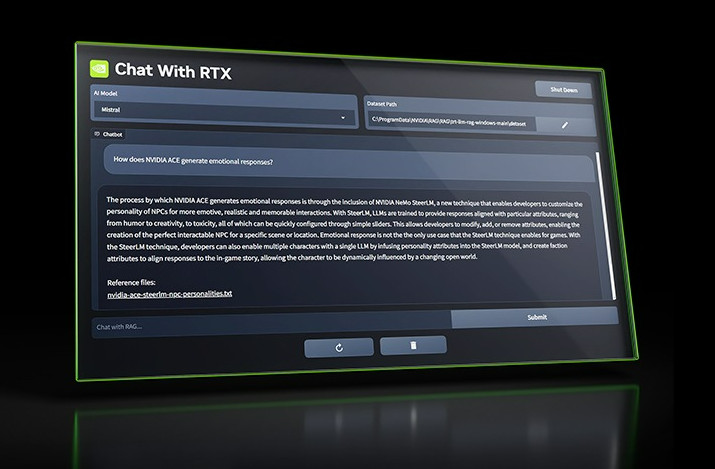

那這個 Chat With RTX 是甚麼作用?其實這與之前的聊天機器人類似 (Chat GPT),但無須使用者透過繁複設定,只要透過搭載 NVIDIA GeForce RTX 30 與 40 系列的 GPU、就能利用顯示卡內建的強大功能輕鬆執行 AI 運算,並非一定得透過雲端大數據中心才能達成,利用檢索增強升成 (RAG)、TensorRT-LLM 和 RTX 加速,可以快速與自訂機器人聊天獲得相關解答,由於是在自家的 Windows RTX PC (或工作站) 上本地運作、無須上網,所以會更快速與安全。

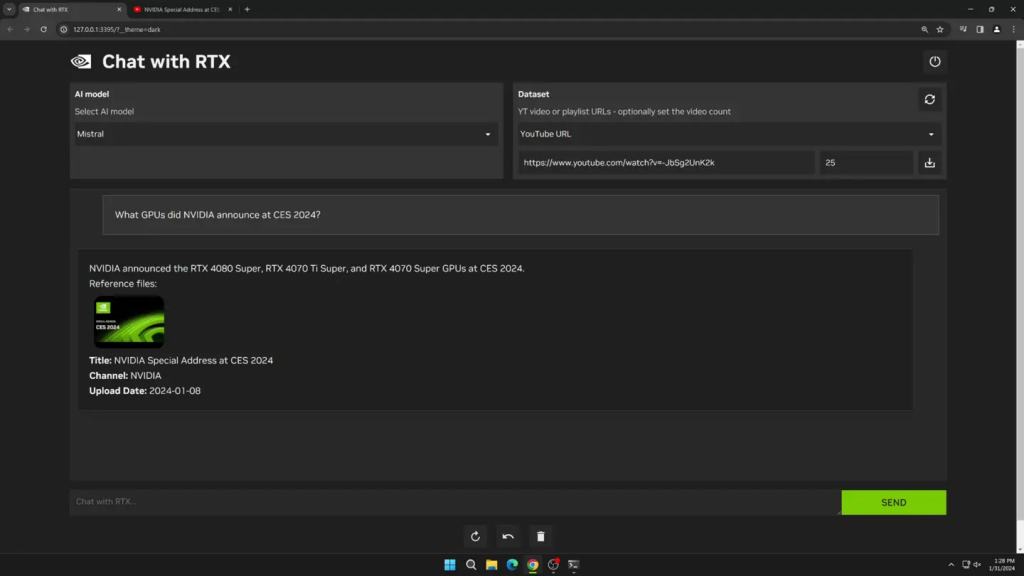

Chat With RTX 支援多種文件格式,包括文字 (TXT)、PDF、DOC/DOCX、XML 等,使用者只需要將執行指向文件夾就能在超短時間內加載到資料庫中,甚至透過 YouTube 播放列表的 URL、也能快速地將其轉錄並查詢涵蓋內容,而從官方的資訊來看,使用者透過與 Chat GPT 相同的方式使用 Chat With RTX、生成的結果則會完全依據特定的數據庫而定,更能適用於生成如摘要、快速搜索文件等面向,另外,支援 TensorRT-LLM 與 RTX GPU 運算也表示可直接透過本地端,不用上網也更能節省時間且獲得更精確的結果。

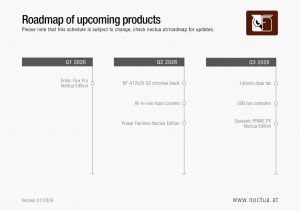

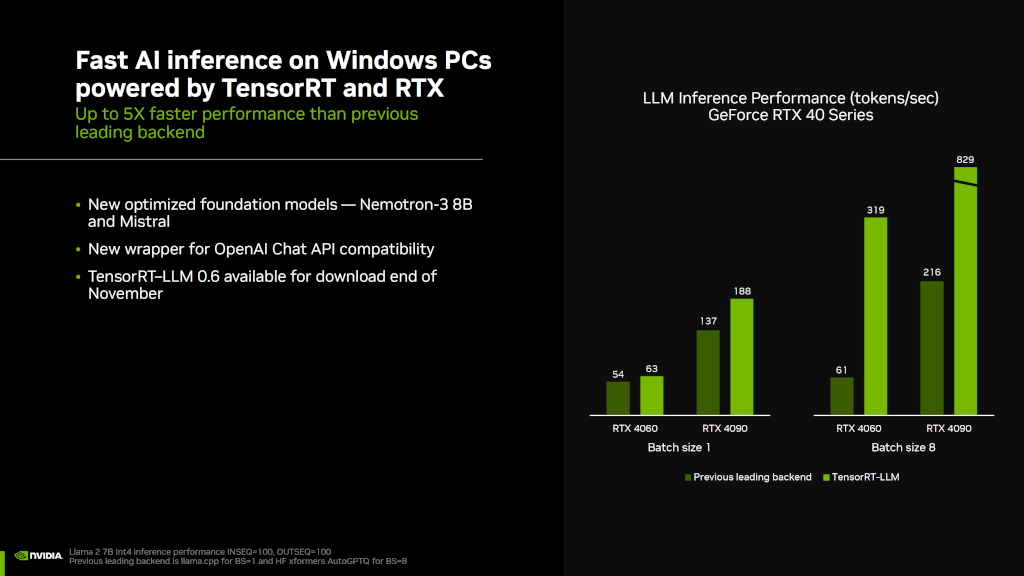

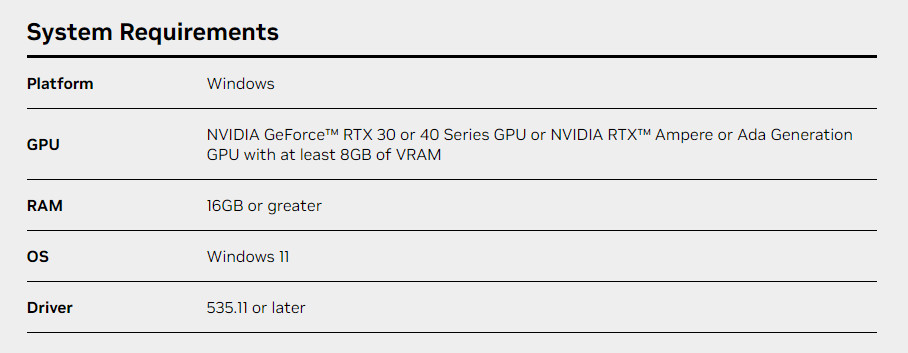

目前的推出時程預計將會在月底前登場,現階段的 TensorRT-LLM v0.6 將能提升 5 倍性能,也支援其他的LLM,像是 Mistral、Nemortron-3 8B 等,目前官方確認僅支援 RTX 30 與 40 GPU、而且需要至少 8GB 記憶體,看來舊款的 RTX 20 系列以及 RTX 3050 6GB 這些版本就無法使用了XD~

更多相關資訊可查閱官方連結:www.nvidia.com/en-us/ai-on-rtx/chat-with-rtx-generative-ai/

▼Create A Personalized AI Chatbot with Chat With RTX