自2026年第3季起,Oracle將成為首家提供搭載50,000個AMD Instinct MI450系列GPU的公共AI超級叢集之超大規模雲端服務供應商

AMD (NASDAQ: AMD) 與 Oracle 在 Oracle AI World 大會上,共同宣布大幅擴展雙方長期且跨世代的合作,協助客戶顯著擴展 AI 能力與相關部署計畫。奠基於多年來的共同創新成果,Oracle Cloud Infrastructure (OCI) 將成為首批合作夥伴,提供搭載 AMD Instinct™ MI450 系列 GPU 的公共 AI 超級叢集,首批將於 2026 年第 3 季部署 50,000 個 GPU,並計畫於 2027 年及未來持續擴大規模。

此項合作奠基於 AMD 與 Oracle 先前共同努力的成果,為終端客戶在 OCI 上提供 AMD Instinct GPU 平台,始於 2024 年推出搭載 AMD Instinct MI300X 的運算型態(shape),並將進一步擴展至搭載 AMD Instinct MI355X GPU 的 OCI Compute 正式上市。這些服務將部署於 Zettascale 等級的 OCI 超級叢集之中。

隨著新世代 AI 模型不斷超越現有 AI 叢集的極限,市場對大規模 AI 運算容量的需求正加速增長。為訓練與運行這些工作負載,客戶需具備極致規模與效率的靈活且開放式運算解決方案。OCI 計劃中的全新 AI 超級叢集將由 AMD「Helios」機架設計挹注動能,結合 AMD Instinct MI450 系列 GPU、代號為「Venice」的新一代 AMD EPYC™ CPU,以及代號為「Vulcano」的新一代 AMD Pensando™先進網路技術。這套垂直最佳化的機架級架構,旨在為大規模 AI 訓練與推論提供極致效能、擴展性與能源效率。

Oracle Cloud Infrastructure 執行副總裁 Mahesh Thiagarajan 表示:「我們的客戶正在建構世界上最前瞻性的 AI 應用,需要強大、可擴展且高效能的基礎設施。透過結合 AMD 最新的處理器創新技術、OCI 安全靈活的平台以及由 Oracle Acceleron 推動的先進網路技術,客戶可以自信地突破極限。透過我們與 AMD 從 EPYC 到 AMD Instinct 加速器長達 10 年的合作,我們將持續攜手為 AI 時代提供最佳性價比、開放、安全且可擴展的雲端基礎,以滿足客戶對新時代 AI 的需求。」

AMD 執行副總裁暨資料中心解決方案事業群總經理 Forrest Norrod 表示:「AMD 與 Oracle 持續引領雲端 AI 的創新節奏。憑藉 AMD Instinct GPU、EPYC CPU 和先進的 AMD Pensando 網路技術,Oracle 客戶獲得強大的新功能,可用於訓練、微調和部署新一代 AI 應用。AMD 與 Oracle 共同透過為大規模 AI 資料中心打造的開放、最佳化且安全的系統,加速 AI 發展。」

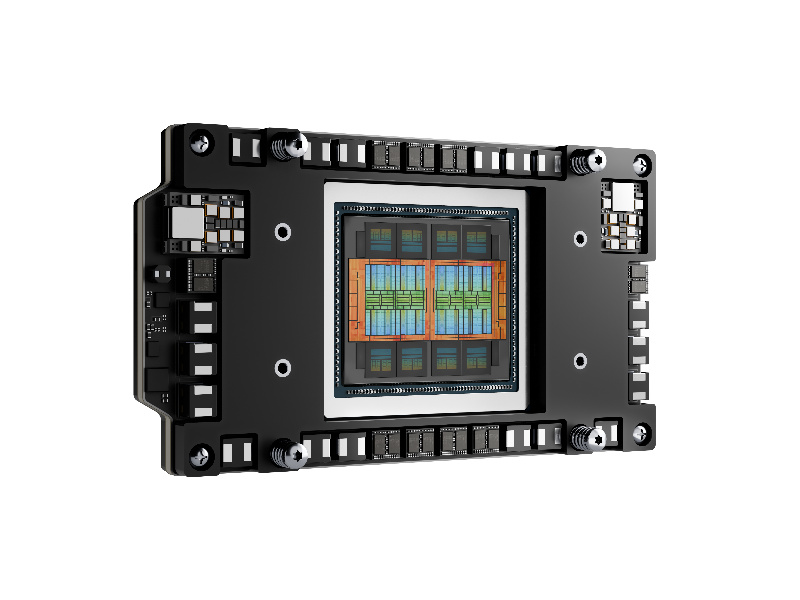

AMD Instinct MI450系列GPU為OCI挹注動能

搭載 AMD Instinct MI450 系列 GPU 的運算型態,旨在提供高效能且靈活的雲端部署選項,並具備廣泛的開源支援。這為客戶運行當今最先進的語言模型、生成式AI和高效能運算(HPC)工作負載提供理想的基礎。透過 OCI 上的 AMD Instinct MI450 系列 GPU,客戶將能受益於:

· 突破性的運算與記憶體技術:透過增加 AI 訓練模型的記憶體頻寬,協助客戶加速成果產出、處理更複雜的工作負載,並降低模型分割的需求。每個 AMD Instinct MI450 系列 GPU 將提供高達 432 GB 的 HBM4 記憶體與 20 TB/s 的記憶體頻寬,讓客戶能夠在記憶體內完整訓練與推論比前一代大 50% 的模型。

· AMD最佳化的「Helios」機架設計:透過高密度、液冷式設計的 72 個 GPU 機架,讓客戶在大規模部署中兼顧最佳化效能密度、成本與能源效率。AMD 「Helios」機架設計整合 UALoE 向上擴展連接性,以及基於乙太網路並符合超高速乙太網路聯盟(UEC)標準的向外擴展網路,以最小化叢集與機架之間的延遲並最大化吞吐量。

· 強大的前端節點:透過採用代號為「Venice」的新一代 AMD EPYC CPU,強化作業編排與資料處理,協助客戶最大化叢集利用率並簡化大規模工作流程。此外,EPYC CPU 將提供機密運算功能和內建安全功能,以端對端保護敏感的 AI 工作負載。

· DPU加速的融合網路:以線速資料擷取提升大規模 AI 與雲端基礎設施效能並強化安全態勢。基於完全可程式化的 AMD Pensando DPU 技術,DPU 加速的融合網路提供資料中心運行新世代 AI 訓練、推論和雲端工作負載所需的安全性和效能。

· AI向外擴展網路:讓客戶能夠利用超高速分散式訓練與最佳化集體通訊,搭配具備未來性的開放式網路架構。每個 GPU 可配備多達 3 個 800 Gbps 的 AMD Pensando “Vulcano” AI 網路卡(AI-NIC),為客戶提供支援先進 RoCE 和 UEC 標準的無損、高速且可程式化連接能力。

· 創新的UALink和UALoE網路架構:協助客戶有效延展工作負載、緩解記憶體瓶頸,並編排大型的數兆參數模型。此可擴展架構能最小化傳輸跳數與延遲,且無需透過 CPU 路由,並透過 UALoE 網路架構傳輸的 UALink 協定,實現機架內 GPU 之間直接且硬體一致的網路互連與記憶體共享。UALink 是專為 AI 加速器打造的開放式高速互連標準,並獲得廣泛產業體系支持。因此,客戶將享有在基於開放標準的基礎設施上運行最嚴苛 AI 工作負載所需的靈活性、擴展性與可靠性。

· 開源AMD ROCm™軟體堆疊:透過為客戶提供開放、靈活的程式設計環境,涵蓋主流框架、函式庫、編譯器和執行環境,實現快速創新、提供供應商選擇自由,並簡化現有 AI 和 HPC 工作負載的遷移。

· 進階分割與虛擬化:透過細粒度 GPU 和叢集分割、SR-IOV 虛擬化技術以及強大的多租戶能力,讓客戶根據工作負載需求分配 GPU,安全且高效地共享叢集資源。

為提供大規模建構、訓練與推論 AI 的客戶更多選擇,OCI 同步宣布搭載 AMD Instinct MI355X GPU 的 OCI Compute 正式上市。這些服務將在可擴展至 131,072 個 GPU 的 Zettascale 等級 OCI 超級叢集中提供。搭載 AMD Instinct MI355X 的運算型態具備高性價比、雲端部署靈活性與開源相容性。