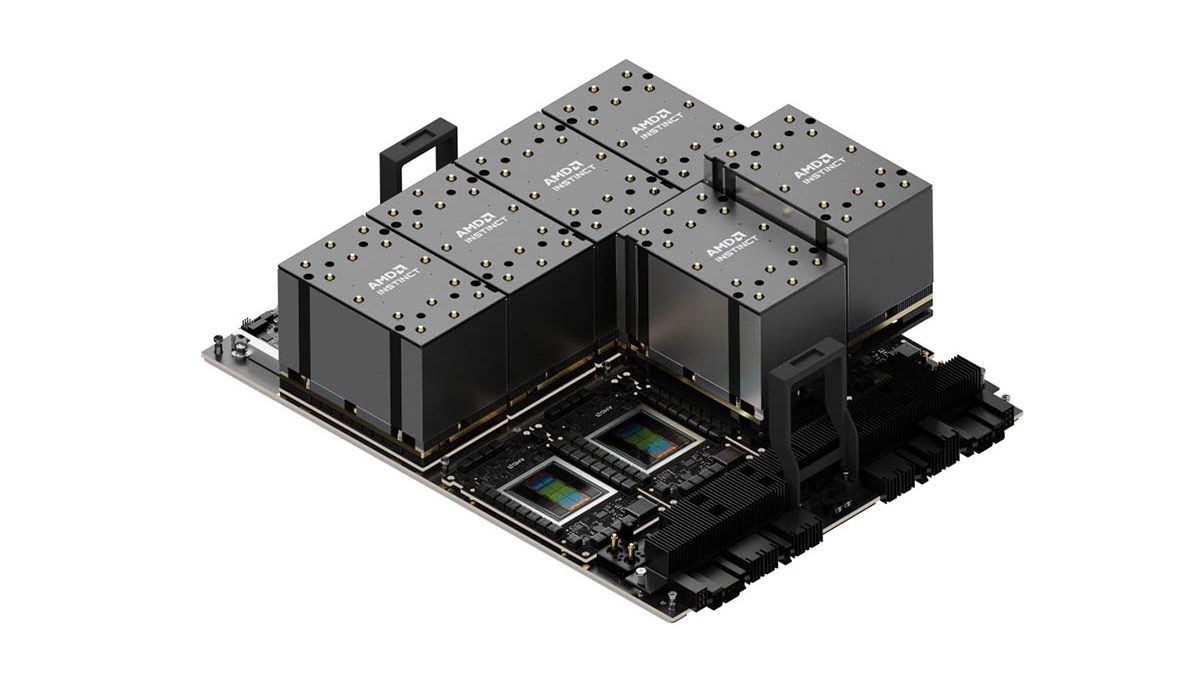

更新AMD Instinct加速器發展藍圖揭示領先業界AI效能與記憶體功能的年度進程

全新AMD Instinct MI325X加速器預計在2024年第4季上市,將配備多達288 GB的HBM3E記憶體;全新AMD Instinct MI350系列加速器採用AMD CDNA 4架構,預計在2025年出貨,較前一代產品的AI推論效能將有35倍的巨幅提升

AMD(NASDAQ: AMD)董事長暨執行長蘇姿丰博士在 COMPUTEX 2024 開幕主題演講中,展現 AMD Instinct™加速器系列的強勢發展動能。AMD 揭示 AMD Instinct 加速器的跨年度產品藍圖,將逐年透過每個世代的 AMD Instinct 加速器挹注 AI 效能與記憶體功能優勢。

在更新版發展藍圖中,率先登場的是將於 2024 年第 4 季問市的全新 AMD Instinct MI325X 加速器。隨後則是 AMD Instinct MI350 系列,採用全新 AMD CDNA™打造,預計在2025年上市,其 AI 推論效能將比 AMD CDNA 3 架構的 AMD Instinct MI300 系列大幅提升 35 倍註1。AMD Instinct MI400 系列則將採用 AMD CDNA “Next”架構,預定在 2026 年問市。

AMD 資料中心加速運算全球副總裁 Brad McCredie 表示,AMD Instinct MI300X 加速器持續受到 Microsoft Azure、Meta、戴爾科技集團、HPE、聯想等眾多合作夥伴與客戶的熱烈採納,充分反映 AMD Instinct MI300X 加速器的卓越效能與價值。在更新版年度產品藍圖的引領下,我們努力不懈地推動創新,提供領先各界的功能與效能,迎合 AI 產業與客戶的期盼,促進資料中心 AI 訓練與推論的新一波革新。

AMD AI軟體產業體系日臻成熟

AMD ROCm™ 6 開放軟體堆疊持續發展完備,助力 AMD Instinct MI300X 加速器為當今最熱門的大型語言模型(LLM)挹注卓越效能。在一部配備 8 個 AMD Instinct MI300X 加速器與 ROCm 6 軟體並運行 Meta Llama-3 70B 模型的伺服器,客戶可獲得相較競爭對手產品提升 1.3 倍的推論效能以及 token 生成吞吐量註2。而憑藉單一 AMD Instinct MI300X 加速器與 ROCm 6 軟體,在運行 Mistral-7B 模型時,客戶可獲得相較競爭對手產品提升 1.2 倍的推論效能以及 token 生成吞吐量註3。AMD 亦披露最大型且最受歡迎的 AI 模型儲存庫 Hugging Face 目前每晚測試 70 萬個最熱門的模型,確保它們能在 AMD Instinct MI300X 加速器上直接運行。此外,AMD 持續拓展與上游領域的合作,包括 PyTorch、TensorFlow 以及 JAX 等熱門 AI 框架。

AMD預覽新款加速器並公佈年度進程藍圖

AMD 在主題演講中揭示 AMD Instinct 加速器藍圖的年度進程,因應各界對運行更多 AI 運算的爆發需求。這也將確保 AMD Instinct 加速器推動新一代前沿 AI 模型的開發。更新後 AMD Instinct 年度藍圖的重點包括:

- 全新 AMD Instinct MI325X 加速器將配備 288 GB 的 HBM3E 記憶體以及每秒 6 terabytes 的記憶體頻寬,沿用和 AMD Instinct MI300 系列相同的產業標準 Universal Baseboard 伺服器設計,預計將於 2024 年第 4 季問市。這款加速器將擁有領先業界的記憶體容量與頻寬,分別比對手高 2 倍與 1.3 倍註4,運算效能則是比對手高 1.3 倍註5。

- AMD Instinct MI350 系列中率先推出的是 AMD Instinct MI350X 加速器,採用 AMD CDNA 4 架構打造,預計在 2025 年上市。新品將沿用和 MI300 系列加速器相同的產業標準 Universal Baseboard 伺服器設計,採用先進 3 奈米製程技術,支援 FP4 與 FP6 AI 資料類型,並配備 288 GB 的 HBM3E 記憶體。

- AMD CDNA “Next” 架構將打造 AMD Instinct MI400 系列加速器,預計在 2026 年上市,將提供眾多最新特色與功能,協助為推論與大規模 AI 訓練挹注額外效能與效率。

AMD 強調各界對 AMD Instinct MI300X 加速器的需求持續成長,眾多合作夥伴與客戶運用加速器運行其要求嚴苛的 AI 工作負載,其中包括:

- Microsoft Azure 運用加速器運行 Azure OpenAI 服務以及新推出的 Azure ND MI300X V5 虛擬機器。

- 戴爾科技集團運用 MI300X 加速器打造 PowerEdge XE9680 運行企業 AI 工作負載。

- 美超微(Supermicro)推出多款採用 AMD Instinct 加速器的解決方案。

- 聯想推出 ThinkSystem SR685a V3 為混合型 AI 創新挹注動能。

- HPE 運用加速器打造 HPE Cray XD675,加速 AI 工作負載。

註1:MI300-55:理效能預測於2024年5月31日進行,使用未來採用AMD CDNA 4的Instinct MI350系列加速器設計的工程估算,作為預計AMD CDNA™ 4效能。評估1.8T GPT MoE模型,假設即時token-to-token延遲為70毫秒,第一個token延遲= 5秒,輸入序列長度=8k,輸出序列長度=256,假設4x 8-mode MI350 series proxy (CDNA4)對比8x MI300X/GPU效能比較。實際效能將根據多種因素而有所不同,包括但不限於生產晶片的最終規格、系統配置以及所使用的推理模型和尺寸。

註2:MI300-54:測試於2024年5月28日由AMD效能實驗室進行,每個系統測試使用尺寸為1及2048個輸入token和128個輸出token生成Llama3-70B文本。

配置:採用2P AMD EPYC 9534 64核心處理器的伺服器,搭載8個AMD Instinct™ MI300X (192GB, 750瓦) GPU,執行Ubuntu® 22.04.1和ROCm™ 6.1.1對比採用2P Intel Xeon Platinum 8468 48核心處理器的伺服器,搭載8個NVIDIA Hopper H100 (192GB, 750瓦) GPU,執行Ubuntu 22.04.3和CUDA® 12.2每個系統中使用了8個GPU進行測試。各家伺服器製造商配置各異,故測得結果亦可能不同。效能可能會根據使用最新驅動程式和最佳化方式而有差異。

註3:MI300-53:測試於2024年5月28日由AMD效能實驗室完成,使用Mistral-7B模型進行文本生成通量測試。測試使用尺寸為56,並對Mistral-7B使用2048個輸入token和2048個輸出token。

配置:採用2P AMD EPYC 9534 64核心處理器的伺服器,搭載8個AMD Instinct™ MI300X (192GB, 750瓦) GPU,執行Ubuntu® 22.04.1和ROCm™ 6.1.1對比採用2P Intel Xeon Platinum 8468 48核心處理器的伺服器,搭載8個NVIDIA Hopper H100 (80GB, 700瓦) GPU,執行Ubuntu 22.04.3和CUDA® 12.2。

此測試僅使用了每個系統的1個GPU。各家伺服器製造商配置各異,故測得結果亦可能不同。效能可能會根據使用最新驅動程式和最佳化方式而有差異。

註4:MI300-48:測試於2024年5月22日由AMD效能實驗室進行的測試基於當前的規格和/或估算。預計AMD Instinct™ MI325X OAM加速器將具有288GB HBM3e記憶體容量和6 TFLOPS的峰值理論記憶體頻寬效能。基於生產晶片的實際結果可能有所差異。

NVIDIA Hopper H200 (141GB) SXM GPU加速器的已公佈的最佳結果顯示141GB的HBM3e記憶體容量和4.8 TB/s的GPU記憶體頻寬效能。

https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVIDIA Blackwell HGX B100(192GB,700瓦)GPU加速器公布的最佳結果顯示192GB的HBM3e記憶體容量和8 TB/s的GPU記憶體頻寬效能。

https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4we%20know%20QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFyTGhYd3hLQmlZQ3pCb0NsVElRQXZEX0J3RQ..*_gcl_au*MTIwNjg4NjU0Ny4xNzExMDM1NTQ3

NVIDIA Blackwell HGX B200(192GB)GPU加速器公布的最佳結果顯示192GB的HBM3e記憶體容量和8 TB/s的GPU記憶體頻寬效能。

https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFyTGhYd3hLQmlZQ3pCb0NsVElRQXZEX0J3RQ..*_gcl_au*MTIwNjg4NjU0Ny4xNzExMDM1NTQ3

註5:MI300-49: 測試於2024年5月28日由AMD效能實驗室進行的測試基於當前的規格和/或估算。AMD Instinct™ MI325X GPU的峰值理論半精度(FP16)效能為1307.4 TFLOPS,峰值理論Bfloat16格式精度(BF16)為1307.4 TFLOPS,峰值理論8位精度(FP8)為2614.9 TFLOPS,INT8浮點效能為2614.9 TOPs。實際效能可能根據最終規格和系統配置而有所差異。預計AMD Instinct™ MI325X OAM加速器將具有288GB HBM3e記憶體容量和6 TFLOPS的峰值理論記憶體頻寬效能。基於生產晶片的實際結果可能有所差異。

NVIDIA H200 SXM(141GB) GPU的已公布結果為:峰值理論半精度tensor(FP16 Tensor)效能為989.4 TFLOPS,峰值理論Bfloat16 tensor格式精度(BF16 Tensor)為989.4 TFLOPS,峰值理論8位精度(FP8)為1,978.9 TFLOPS,峰值理論INT8浮點效能為1,978.9 TOPs。NVIDIA使用稀疏度發布了BFLOAT16 Tensor Core、FP16 Tensor Core、FP8 Tensor Core和INT8 Tensor Core的效能;為了進行比較,AMD將這些數字轉換為非稀疏/密集,以上數字為除以2轉換後的結果。

NVIDIA H200資源:https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 and https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

NVIDIA H200 GPU具有與H100產品相同的FLOPs效能:https://resources.nvidia.com/en-us-tensor-core/