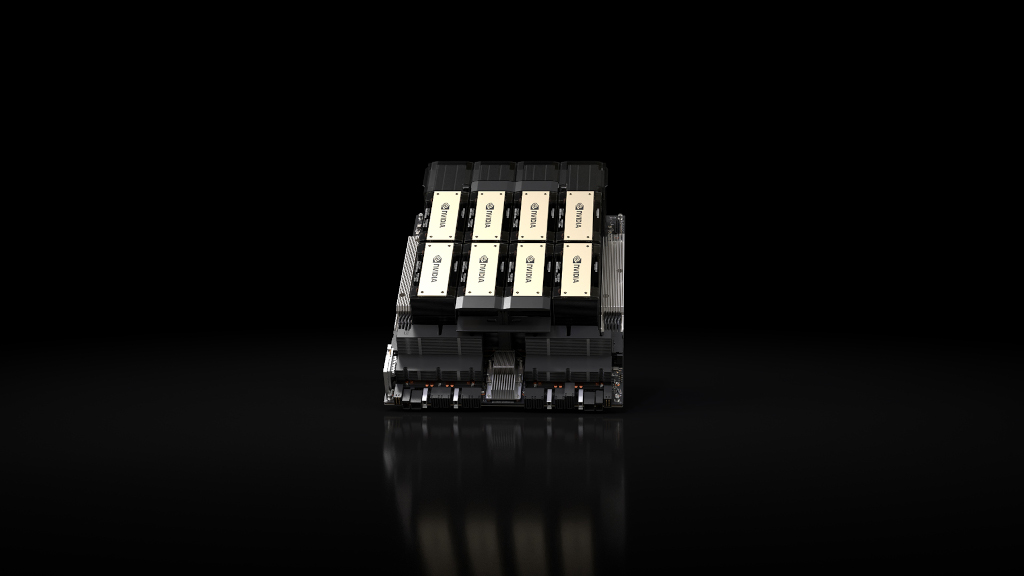

NVIDIA (NASDAQ: NVDA) 今天宣布推出 NVIDIA HGX™ H200,為全球領先的人工智慧運算平台帶來強大動力。該平台基於 NVIDIA Hopper™ 架構,配備 NVIDIA H200 Tensor Core GPU,並具有先進的記憶體,可為生成式人工智慧和高效能運算的工作負載處理大量資料。

NVIDIA H200 是首款提供 HBM3e 的 GPU,HBM3e 是速度更快、容量更大的記憶體,可加速生成式人工智慧和大型語言模型,同時推進高效能運算工作負載的科學運算。借助 HBM3e,NVIDIA H200 以每秒 4.8 TB 的速度提供 141GB 記憶體,與其前代產品 NVIDIA A100 相比,容量幾乎翻倍,頻寬增加 2.4 倍。

全球領先伺服器製造商和雲端服務供應商採用 H200 的系統預計將於 2024 年第二季開始出貨。

NVIDIA 超大規模與高效能運算部門副總裁 Ian Buck 表示:「要透過生成式人工智慧和高效能運算應用程式創造智慧,必須使用大型、快速的 GPU 記憶體來高速有效地處理大量資料。憑藉 NVIDIA H200,業界領先的端到端人工智慧超級運算平台速度變得更快,能夠解決世界上一些最重要的挑戰。」

持續的創新,持續的效能躍進

NVIDIA Hopper 架構與其前代架構相比,實現了前所未有的效能躍進,並透過 H100 的持續軟體增強,包括像是最近釋出 NVIDIA TensorRT™-LLM 這種強大的開源庫,不斷提高效能水準。

H200 的推出將帶來更進一步的效能躍進,包括相對於 H100,在 Llama 2 這樣一個擁有 700 億參數大型語言模型上的推論速度將近翻倍提升。未來的軟體更新預計將為 H200 帶來額外效能的領先優勢,並持續最佳化 H200。

NVIDIA H200的外型與規格

NVIDIA H200 將提供包含具有四路和八路配置的 NVIDIA HGX H200 伺服器主機板,其軟硬體皆與 HGX 100 系統相容。此外,NVIDIA H200 亦可與今年 8 月推出、採用 HBM3e 的 NVIDIA GH200 Grace Hopper™ 超級晶片搭配使用。

透過這些選項,H200 可以部署在各種類型的資料中心中,包括本地、雲端、混合雲和邊緣環境。 NVIDIA 全球生態系合作夥伴伺服器製造商,包括永擎電子、華碩、戴爾科技集團、Eviden、技嘉科技、慧與科技、鴻佰科技、聯想、雲達科技、美超微、緯創資通和緯穎科技,都可以輕鬆使用基於 H200 的直接替換方式來更新其基於 H100 的系統。

除了 CoreWeave、Lambda 和 Vultr 之外,從明年開始,亞馬遜網路服務、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure 也將成為第一批部署基於 H200 執行個體的雲端服務供應商。

HGX H200 由 NVIDIA® NVLink™ 和 NVSwitch™ 高速互連技術驅動,可為各種應用工作負載提供最高效能,包括針對超過 1750 億個參數的最大模型,進行大型語言模型訓練和推論。

八路 HGX H200 提供超過 32 petaflops 的 FP8 深度學習運算和 1.1TB 總高頻寬記憶體,可在生成式人工智慧和高效能運算應用中實現最高性能。

當與搭載超快速 NVLink-C2C 互連技術的 NVIDIA Grace™ CPU 搭配使用時,H200 創造了搭載 HBM3e 的 GH200 Grace Hopper 超級晶片,這是一個專門設計來用於大規模高效能運算和人工智慧應用的整合模組。

使用NVIDIA全端軟體加速人工智慧

NVIDIA 的加速運算平台得到強大的軟體工具支援,這些工具使開發人員和企業能夠建構並加速從人工智慧到高效能運算的生產就緒型應用程式。這其中包括 NVIDIA AI Enterprise 軟體套件,用於語音、推薦系統和大規模推論等工作負載。

上市時間

全球系統製造商和雲端服務供應商將於 2024 年第二季開始提供 NVIDIA H200 。