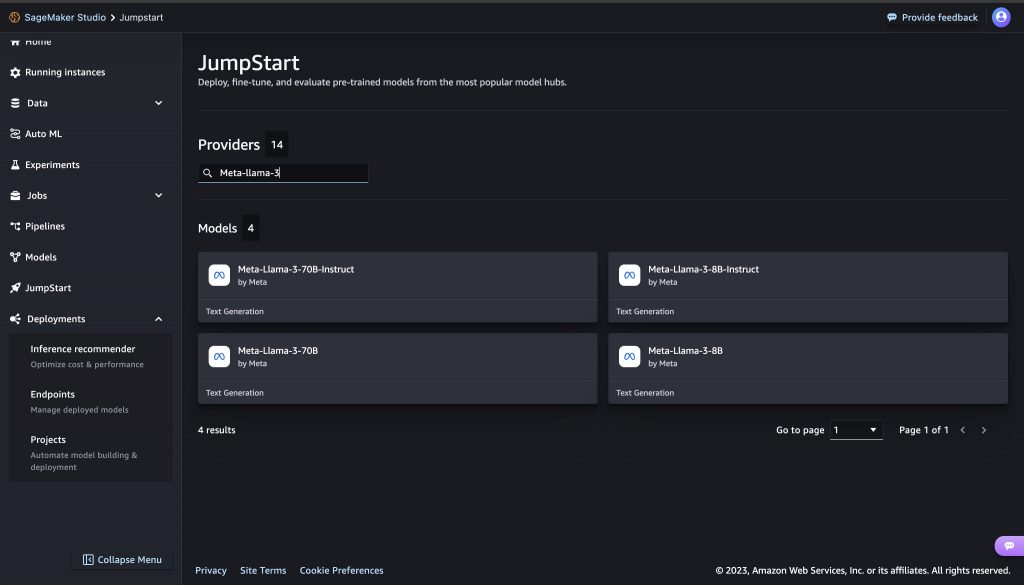

Amazon Web Services(AWS)宣布,Meta 剛剛發布的兩款 Llama 3 基礎模型 Llama 3 8B 和 Llama 3 70B 現已在 Amazon SageMaker JumpStart 中提供。這兩款模型的上下文長度(Context Length)為 8k,能夠支持廣泛的應用案例,並在推論、程式碼生成和指令跟隨等方面有所改進。客戶可以在 Amazon SageMaker JumpStart 中輕鬆部署 Llama 3 基礎模型,並運行推論。

Llama 3 提供 8B 和 70B 兩種參數大小的模型,上下文長度為 8k,能夠支持廣泛的應用。Llama 3 使用了僅含解碼器的 Transformer 架構,以及高達 128k 規模的新型分詞器,極大提升了模型的效能。此外,Meta 改進的訓練後處理常式大幅降低了誤拒率,提高了模型回應的一致性和多樣性。

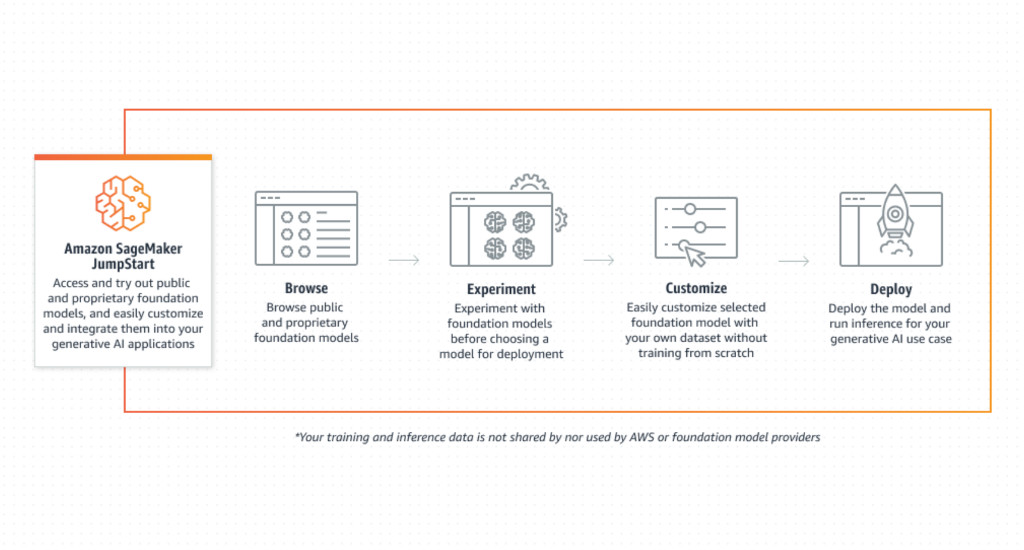

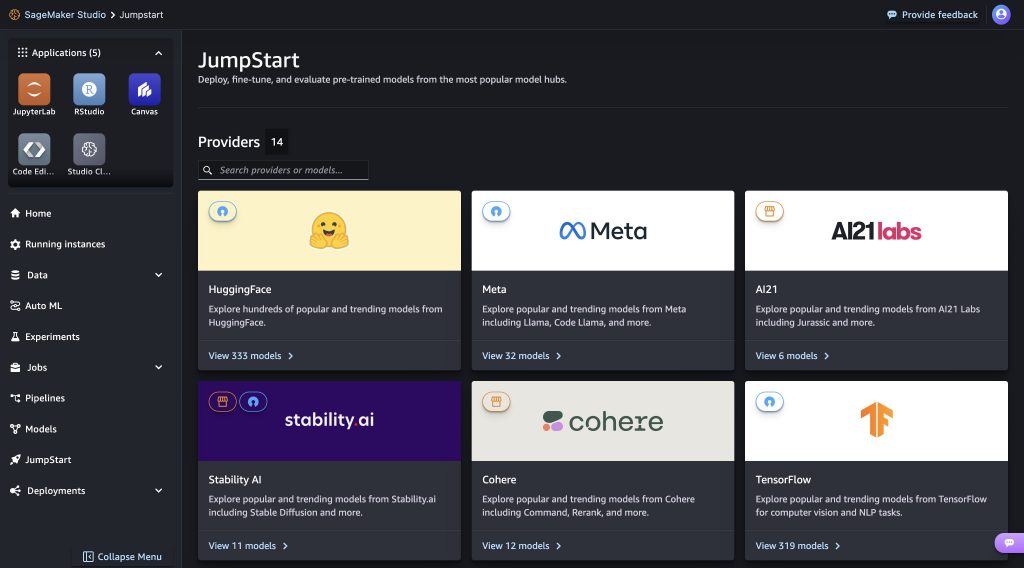

Amazon SageMaker JumpStart 提供預訓練的模型、內置演算法和預建構的解決方案,幫助客戶快速開始機器學習專案。Amazon SageMaker JumpStart 能夠幫助客戶從廣泛的公開可用基礎模型中進行選擇,並將基礎模型部署到專用的 SageMaker 實例中,這些實例位於網路隔離的環境,並可以使用 SageMaker 進行模型訓練和部署。

客戶現在可以在 Amazon SageMaker Studio 中透過點擊或透過 SageMaker Python SDK 程式設計方式部署Llama 3模型,還可以利用 SageMaker Pipelines、SageMaker Debugger 或容器日誌等功能,提升模型效能並實施 MLOps 控制。此外,該方式部署的模型始終處在 AWS 的安全環境下,由客戶的 VPC(Virtual Private Cloud)控制,以確保資料安全。

Meta Llama 3 基礎模型現已在 Amazon SageMaker Studio 的美東(北維吉尼亞州)、美東(俄亥俄州)、美西(奧勒岡州)、歐洲(愛爾蘭)和亞太(東京)區域提供部署和推論服務。