ComfyUI、LTX-2、Llama.cpp、Ollama、Hyperlink等多項工具迎來全面RTX加速,解鎖AI PC上的影片、影像與文字生成應用

2025 年是 PC 端 AI 開發的突破之年。PC 等級的小型語言模型(SLM)準確度相較 2024 年幾乎提升近 2 倍,大幅縮小與雲端前沿大型語言模型(LLM)之間的差距。

同時,Ollama、ComfyUI、llama.cpp、Unsloth 等 AI PC 開發者工具日趨成熟,年成長率翻倍;下載 PC 等級模型的使用者數量,也較 2024 年成長 10 倍。上述進展正推動生成式 AI 在 2026 年全面走向日常 PC 創作者、遊戲玩家與專業工作者。

在本週 CES 展會上,NVIDIA 宣布為 GeForce RTX、NVIDIA RTX PRO 與 NVIDIA DGX Spark 推出一系列 AI 升級,為開發者在 PC 上部署生成式 AI 提供所需的效能與記憶體資源,包括:

- ● 透過 PyTorch-CUDA 最佳化,以及 ComfyUI 原生支援 NVFP4/FP8 精度,影片與影像生成效能最高提升 3 倍,VRAM 使用量降低 60%

- ● RTX 影像超解析度整合至 ComfyUI,加速 4K 影片生成

- ● 針對 Lightricks 最尖端的 LTX-2 聲音與影像生成模型開源版,提供最佳化NVIDIA NVFP8

- ● 一套全新影片生成流程,透過 Blender 3D 場景,精準控制輸出並生成 4K AI 影片

- ● 透過 Ollama 與 llama.cpp,將 SLM 推論效能提升最高 35%

- ● 為 Nexa.ai 的 Hyperlink 新一代影片搜尋功能提供 RTX 加速

這些升級讓使用者能在本地 RTX AI PC 上,順暢執行進階的影片、影像與語言 AI 工作流程,同時兼顧隱私、安全與低延遲。

在RTX PC上實現3倍加速的4K AI影片生成

生成式 AI 能製作出令人驚艷的影片內容,但僅靠文字提示的線上工具往往難以精準控制生成內容;嘗試生成 4K 影片更是幾乎不可能,因為多數模型過於龐大,難以放入 PC 的 VRAM。

1月6日,NVIDIA 推出 RTX 加速的影片生成流程,讓創作者在使用極少 VRAM 的情況下,不僅能更精準掌控生成結果,還能以 3 倍速度生成影片並將提升至 4K 解析度。

此流程讓新銳創作者可先建立分鏡腳本,再生成擬真關鍵畫格,最終輸出高品質 4K 影片。整體分為三個可自由搭配、依需求調整的模組:

- ● 3D 物件生成器:用於建立場景所需的資產

- ● 3D 引導影像生成器:讓使用者在 Blender 中設定場景,並生成擬真關鍵畫格

- ● 影片生成器:依據使用者設定的起始與結束關鍵畫格進行動畫生成,並透過 NVIDIA RTX Video 技術將影片升級至 4K

這套流程得以實現,關鍵在於 Lightricks 全新 LTX-2 模型的正式釋出,該模型現已開放下載。

作為本地 AI 影片創作的重要里程碑,LTX-2 的生成效果可與頂尖的雲端模型並駕齊驅,能生成長達 20 秒且具備出色視覺擬真度的 4K 影片。該模型內建音訊支援、多關鍵畫格能力,以及進階的條件控制功能,並透過可控式低秩適配(LoRA)強化,讓創作者在不依賴雲端的情況下,也能達到電影級的品質與控制力。

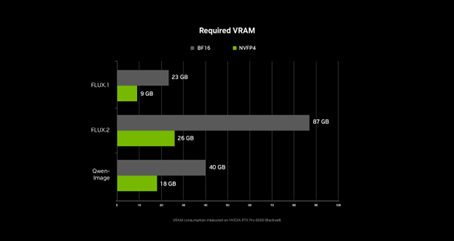

在底層技術上,這套流程由 ComfyUI 驅動。過去數月,NVIDIA 與 ComfyUI 團隊密切合作,在 NVIDIA 顯示卡上將效能最佳化 40%;最新版本新增支援 NVFP4 與 NVFP8。在 RTX 50 系列顯示卡上採用 NVFP4 格式時,可讓效能提升 3 倍、VRAM 使用量降低 60%;採用 NVFP8 時,則可提升 2 倍效能、VRAM 降低 40%。

目前,NVFP4 與 NVFP8 Checkpoint 現已在 ComfyUI 中直接開放給多款頂尖模型,包括 Lightricks 的 LTX-2、Black Forest Labs 的 FLUX.1 與 FLUX.2,以及阿里巴巴的 Qwen-Image 與 Z-Image。使用者可直接在 ComfyUI 下載,後續也將陸續支援更多模型。

影片片段生成後,使用者可透過 ComfyUI 全新的 RTX Video 節點,在數秒內將影片升級至 4K。此影像放大(Upscaler)功能可即時運作,銳化畫面邊緣並消除壓縮雜訊,輸出清晰的畫面。RTX Video 將於下個月正式於 ComfyUI 中開放。

為協助使用者突破顯示卡的記憶體限制,NVIDIA 也與 ComfyUI 合作強化其記憶體卸載功能(weight streaming)。啟用後,當 VRAM 不足時,ComfyUI 可改用系統記憶體,讓中階 RTX 顯示卡也能執行更大型模型與更複雜的多階節點流程。

完整的影片生成工作流程將於下個月開放下載;LTX-2 影片模型的開源權重與 ComfyUI RTX 相關更新現已上線。

全新的PC檔案與影片搜尋方式

數十年來,PC 上的檔案搜尋方式幾乎沒有改變,仍主要依賴檔名與零散、不完整的中繼資料,讓使用者要找出一年前的特定文件,往往困難許多。

由 Nexa.ai 推出的本地搜尋代理 Hyperlink,能將 RTX PC 轉變為一個可搜尋的知識庫,使用者可透過自然語言提問,並即時取得附有引用來源的答案。Hyperlink 可掃描並索引文件、簡報、PDF 與圖像,讓搜尋依據內容與概念進行,而不再只是猜檔名。所有資料皆在本地處理並保留於使用者的 PC 中,兼顧隱私與資安需求。此外,Hyperlink 也透過 RTX 加速大幅提升效能,在 RTX 5090 顯示卡上,索引文字與影像檔案僅需 每 GB 約 30 秒,回應時間約 3 秒;相較之下,僅使用 CPU 時,索引每 GB 檔案需 約 1 小時,回應時間約 90 秒。

在 CES 2026 展會上,Nexa.ai 也首度公開支援影片內容的 Hyperlink 測試版本,讓使用者可在影片中搜尋物件、動作與語音內容。這項功能特別適合影片創作者快速尋找 B-roll 素材,也能讓玩家找出自己贏得比賽的精彩時刻,分享給朋友。

有興趣體驗 Hyperlink 私有測試版本的使用者,敬請造訪 Nexa.ai 官網登記申請,測試資格將自本月起陸續開放。

小型語言模型(SLM)效能再提升35%

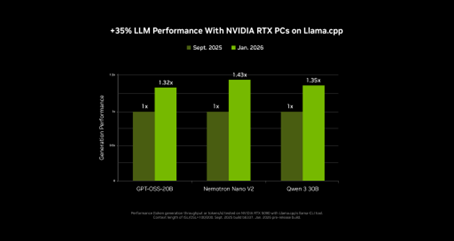

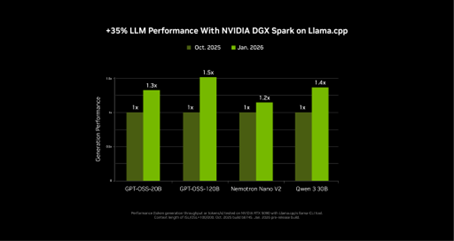

NVIDIA 攜手開源社群,透過 Llama.cpp 與 Ollama,在 RTX顯示卡與NVIDIA DGX Spark 桌上型超級電腦上為 SLM 帶來顯著的效能提升。此次更新對混合專家模型(MoE)特別有利,包含全新的 NVIDIA Nemotron 3 系列開放模型。

在過去四個月中,SLM 的推論效能已有明顯進展,在 llama.cpp 上提升了 35%,在 Ollama 上提升了 30%。目前 Ollama 的更新已正式推出;llama.cpp 也已加入改善使用體驗的更新,大幅加快大型語言模型(LLM)的載入速度,並預計於 1 月稍晚陸續推出更多更新。

這些效能提升將納入 LM Studio 的下一次更新,並陸續導入代理型應用程式,例如全新的 MSI AI Robot 應用。MSI AI Robot 同樣受益於 Llama.cpp 的最佳化,讓使用者能以自然語言方式控制 MSI 裝置設定,並將在即將推出的版本中整合最新更新內容。

NVIDIA Broadcast 2.1:讓更多PC使用者體驗虛擬補光效果

NVIDIA Broadcast 應用程式透過 AI 特效提升 PC 麥克風與網路攝影機的音訊與影像品質,非常適合用於直播與視訊會議。

在 2.1 版更新中,NVIDIA 進一步強化虛擬補光(Virtual Key Light)效果,不僅提升整體效能,也將支援範圍擴大至 RTX 3060 桌機顯示卡以上。新版可因應更多元的光源情境,提供更廣泛的色溫調整,並採用更新後的 HDRi 底圖,呈現專業直播中常見的雙主燈風格。欲下載最新版本,敬請造訪 NVIDIA Broadcast 官網。

以DGX Spark將居家創作工作室升級為AI超級工作站

隨著功能日益強大的 AI 模型每月持續登上 PC 平台,開發者對於更高效、彈性更大的本地 AI 環境需求也不斷升溫。DGX Spark 是一款可直接放置於桌面的精巧 AI 超級電腦,能與既有的桌機或筆電無縫搭配,讓使用者在原有 PC 旁,同步進行實驗、原型設計與進階 AI 工作負載。

DGX Spark 非常適合想測試 LLM、開發代理型工作流程的使用者,也適合創作者在背景平行生成素材,同時保留主力電腦持續進行剪輯與創作。

在 CES 2026 展會上,NVIDIA 宣布為 DGX Spark 推出重大的 AI 效能升級,自產品推出不到三個月以來,整體效能提升最高 2.6 倍。

此外,NVIDIA 也同步釋出多款全新的 DGX Spark 教學範例,其中包含用於推測式解碼(Speculative Decoding) 的範例,以及利用兩台 DGX Spark 模組進行模型微調 的實作指南。